Según se ha comentado en un artículo anterior, aun cuando la interpretación del término "Big Data" es variada, al autor de este artículo le gusta hablar de Big Data cuando nos vemos obligados a recurrir a la computación distribuida para analizar un conjunto de datos, pero ¿qué puede llevarnos a esta necesidad? Hay un par de factores principales:

- El primero es el volumen de datos. Si la cantidad de datos a analizar excede la capacidad de un ordenador, ya podemos decir que nos encontramos en un entorno de Big Data. Esto significa, hoy en día, que cualquier volumen de datos por encima de unos pocos terabytes puede ser ya considerado Big Data.

- El segundo es la velocidad a la que es necesario analizar los datos. Si el volumen de datos a analizar no es tan alto pero la complejidad de su análisis hace que no sea posible usando un único ordenador, también nos encontraríamos en un escenario de datos masivos. Un ejemplo puede ser el análisis de datos no estructurados como imágenes de vídeo.

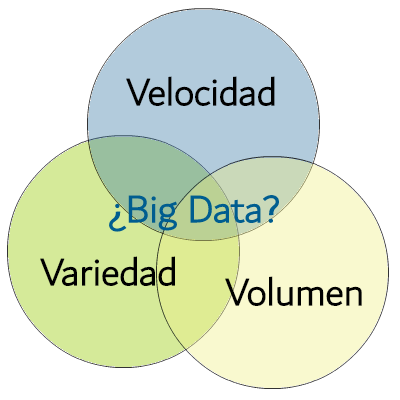

Y fijémonos en que cualquiera de estos dos motivos por sí solos puede obligarnos a recurrir a la computación distribuida. Entonces ¿qué es el modelo de las 3 V's? Según Gartner (e IBM posteriormente), un escenario Big Data abarca tres dimensiones: Volumen de datos, Velocidad de análisis y Variedad de fuentes de datos. Sin embargo, acabamos de ver que no es necesario que se den estas tres características: el Volumen o la necesidad de Velocidad por sí solas pueden obligarnos a recurrir a la computación distribuida. De hecho, es cierto que en un entorno Big Data suelen existir varias fuentes de datos, pero ¿qué ocurre si solo hay una fuente? (por ejemplo, los datos procedentes de un sensor que transmite en tiempo real algún tipo de información). Si su análisis impide recurrir a un único ordenador ¿no es ya un escenario de Big Data? Por supuesto que lo es.

El modelo de las tres V's no es más que una curiosidad sin mayor valor. De hecho, hay una cuarta V que debemos a IBM: la Veracidad de los datos. ¿Y en qué tipo de análisis no es importante que los datos sean veraces? En todos, tanto en entornos de datos masivos como en entornos tradicionales, resulta crítico que los datos que estamos manejando sean veraces pues, de otra forma, se perdería toda la credibilidad en el resultado y, por lo tanto, en el proyecto en el que el proceso de análisis esté involucrado.

Y, en un arranque de originalidad, se ha añadido al conjunto una quinta V: el Valor. Y es que el resultado del análisis debe aportar valor a la empresa (a lo que podemos responder con la misma pregunta que nos hicimos hace poco: ¿en qué tipo de análisis no es importante que se aporte valor?).

La única curiosidad de este supuesto modelo es la coincidencia de que las palabras en las que se basa comienzan por V. Pero, en la práctica, lo que debe llevarnos a calificar un escenario de datos masivos o no, no es una curiosidad de este tipo, sino los requerimientos del análisis.