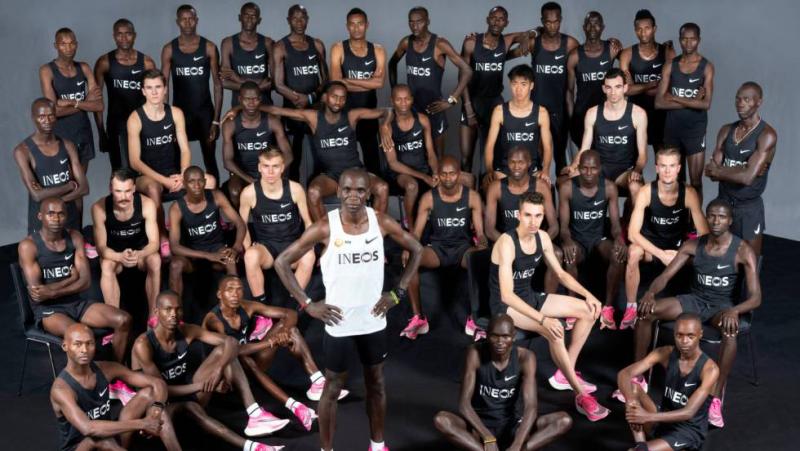

Tuve ocasión recientemente de asistir a una ponencia sobre la “justicia” e “injusticia” de los algoritmos. Se planteó el concepto de sesgo en los algoritmos (debido a datos descompensados, insuficientes, etc.) y se planteó cómo los algoritmos deberían ser entrenados para que no planteasen diferencias en variables “sensibles” (la edad, el sexo, la raza…). En cierto momento el ponente comentó algo como “…porque, si estamos hablando de la predicción de solvencia de solicitantes de un préstamo, no debería haber diferencias entre hombres y mujeres ¿cierto?”, esperando la aquiescencia del público. El pensamiento que pasó por mi cabeza fue “Pues no lo sé, necesitaría datos. Porque si estuviésemos hablando de la predicción del riesgo de accidente de un conductor, también podría esperarse que no hubiera diferencias entre hombres y mujeres. O si estuviésemos hablando de la marca de un corredor de fondo, también podría esperarse que no hubiera diferencias entre corredores de la que llamamos ‘raza blanca’ y los de ‘raza negra’. O si estuviésemos hablando de la estimación de vida de una persona, también podría esperarse que no hubiera diferencias entre hombres y mujeres”. Pero la realidad es tozuda, y las mujeres tienen menos accidentes que los hombres, los corredores de raza negra tienen marcas mucho mejores que los de raza blanca, y los hombres viven menos que las mujeres. Llegué rápidamente a la conclusión de que aquella ponencia no estaba dedicada a la justicia e injusticia de los algoritmos, sino a lo que hoy día se interpreta como “políticamente correcto” o “incorrecto”.

El problema de forzar un algoritmo para que su resultado sea “políticamente correcto” es que, sencillamente, podemos estar dando la espalda a la realidad. Sin negar en absoluto que en ciertas condiciones sea conveniente la discriminación positiva, el riesgo que corremos al intentar imponer una ideología a la realidad puede ser elevado. Me imaginé a un médico analizando la posibilidad de que un tumor que afecte de forma diferente a hombres y mujeres sea maligno o benigno, esté en un estado de desarrollo u otro, o sea de un tipo u otro. Una búsqueda rápida en internet nos ofrece infinidad de casos: un ejemplo puede ser el “Estudio de glioblastoma destaca las diferencias de sexo en el cáncer de cerebro”, del Instituto Nacional del Cáncer (primer resultado que me ofreció la búsqueda). En mi opinión, asegurar esa supuesta “justicia” del algoritmo puede suponer el mayor sesgo que podemos cometer y -en casos como el comentado del cáncer de cerebro- podemos incluso estar poniendo en peligro la vida de una persona.

De forma que, de vuelta a la cuestión inicial de ¿hombres y mujeres ofrecen la misma solvencia? mi respuesta seguía siendo “No lo sé, por justo o injusto que parezca. Quizás ellos o ellas sean más o menos precavidos, más o menos prácticos, o mejores o peores gestores. No lo sé, ni quiero prejuzgarlos”. Y esto sin contar con que nadie se basaría en un análisis univariante para tomar una decisión de este tipo. La realidad es infinitamente más compleja y la forma en la que una variable como el sexo o la raza influye en una predicción es algo mucho más sutil de lo que puede parecer. En un caso como éste tal vez no estemos poniendo la vida de nadie en peligro, pero sí estamos corriendo el riesgo de desvirtuar la realidad en aras de esa “justicia social”.

Reconozco que, tras pasar por mi cabeza estos pensamientos, dejé de prestar atención a la ponencia.