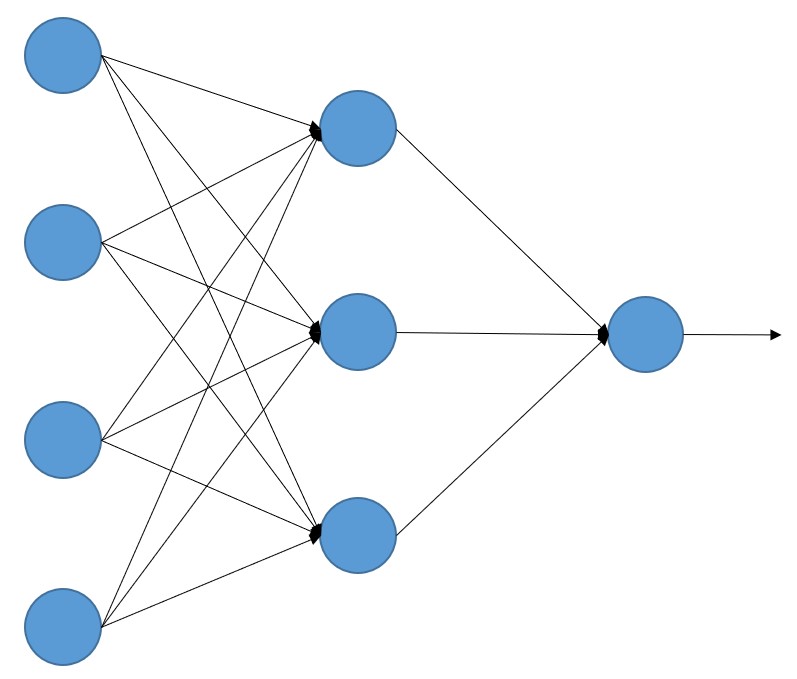

Como se ha comentado, la arquitectura de los preceptrones multicapa (MLP) es la más sencilla posible: se trata de redes de tipo "feedforward" en las que tenemos una capa de entrada, una o varias capas ocultas y una capa de salida, y donde la información fluye desde la entrada hacia la salida sin bucles ni comunicación entre las neuronas de una misma capa. Por ejemplo:

Vamos a crear un MLP usando la librería scikit-learn y aplicarlo a un sencillo escenario de clasificación de imágenes.