En los Soft Margin Classifiers, a las muestras que son clasificadas erróneamente se les asocia una penalización que depende de lo lejos que se encuentren del área correcta en la que deberían estar incluidas, siendo el objetivo de estos modelos el obtener el mayor margen posible con la mínima penalización total.

En estos clasificadores, se introduce un parámetro de regularización C que controla el equilibrio entre el doble objetivo de maximizar el margen y minimizar el error cometido. C multiplica a los errores cometidos, de forma que un valor bajo de C tiende a penalizar poco los errores, permitiendo márgenes mayores a costa de cometer más errores (baja regularización), mientras que un valor alto de C penaliza mucho los errores, llevando al modelo a cometer menos errores a costa de un margen menor (alta regularización).

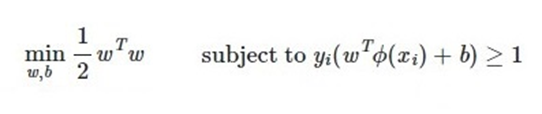

De esta forma, la función de coste en un modelo de máximo margen es:

(es decir, el objetivo es maximizar el margen -lo que se consigue minimizando cierto vector w-, asegurándonos de que los puntos de nuestro dataset están en el lado correcto)

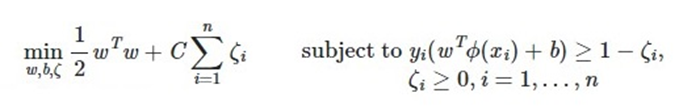

Mientras que, en un clasificador de margen blando, la función de coste pasa a ser:

Es decir, ahora el objetivo sigue siendo maximizar el margen, pero añadiendo como penalización los errores cometidos multiplicados por el parámetro de regularización C.