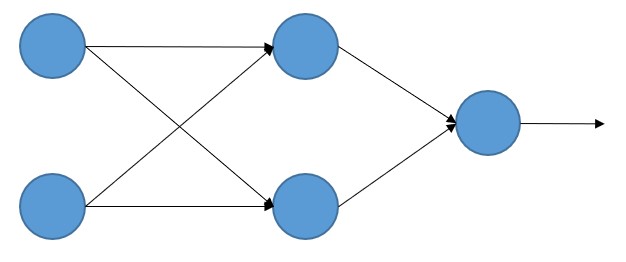

Como se ha comentado, la red neuronal está formada por neuronas situadas en diferentes capas y conectadas unas a otras, neuronas que, en los esquemas mostrados, se representan por medio de círculos. Por ejemplo, el siguiente MLP (perceptrón multicapa) tiene dos valores de entrada, una capa oculta con dos neuronas, y una capa de salida con una neurona:

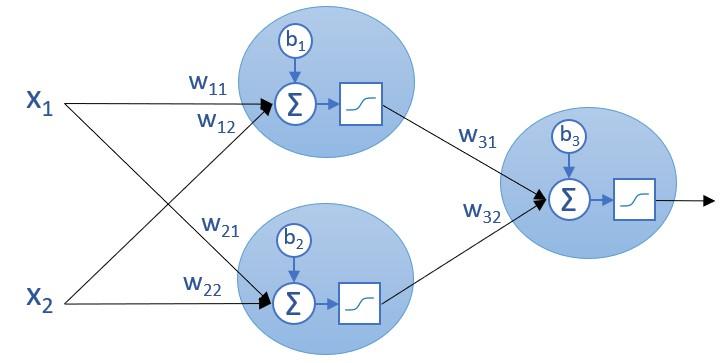

Si sustituimos cada neurona por el esquema visto en secciones anteriores en el que se muestra la función sumatorio y la función de activación, el resultado sería el siguiente:

Apreciamos ahora que cada neurona mantiene un comportamiento independiente de las demás: cada una recibe un conjunto de valores de entrada (un vector de entrada), calcula el producto escalar de dicho vector y el vector de pesos, añade su propio bias, aplica al resultado una función de activación, y devuelve el resultado final obtenido.

En general, todos los pesos y bias serán diferentes. Las funciones de activación podrán ser o no diferentes en función de la librería que se esté utilizando para crear la red neuronal. Scikit-Learn, por ejemplo, solo permite aplicar una misma función de agregación a todas las neuronas de las capas ocultas. Keras, por otro lado, permite escoger para cada capa una función de activación diferente.

Se observa también en el esquema anterior cómo las "neuronas" de la capa de entrada han sido sustituidas, simplemente, por los valores de entrada (x1 y x2).

En función de nuestros intereses en cada momento recurriremos a un diagrama u otro para representar una red neuronal.