La arquitectura más simple es la llamada Perceptrón Multicapa o Multilayer Perceptron (MLP), aunque debemos tener en cuenta que la presencia de la palabra "perceptrón" en este nombre no es más que una herencia histórica pues, de hecho, un perceptrón multicapa no está formado por perceptrones, sino por neuronas sigmoideas o por neuronas con otro tipo de función de activación (ReLu, etc.), tal y como veremos más adelante.

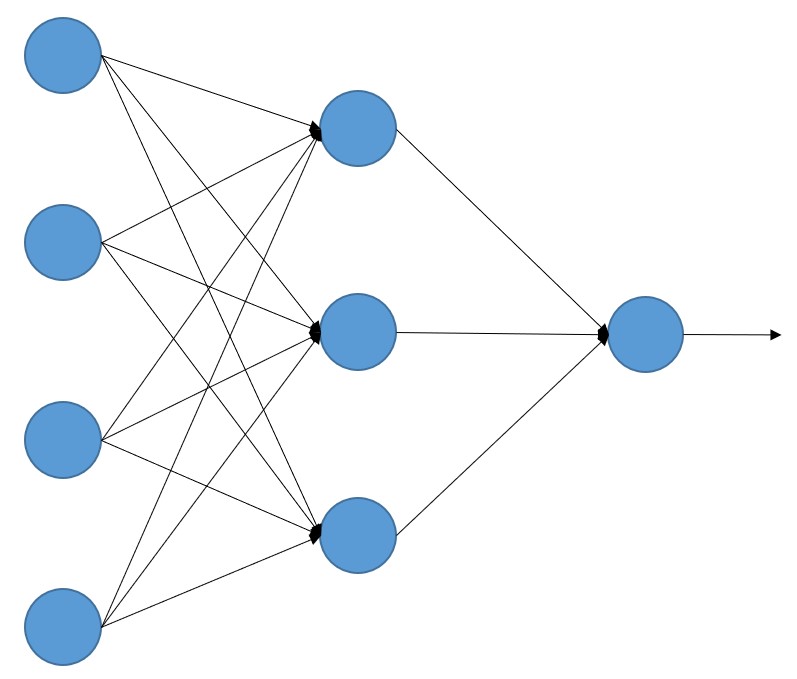

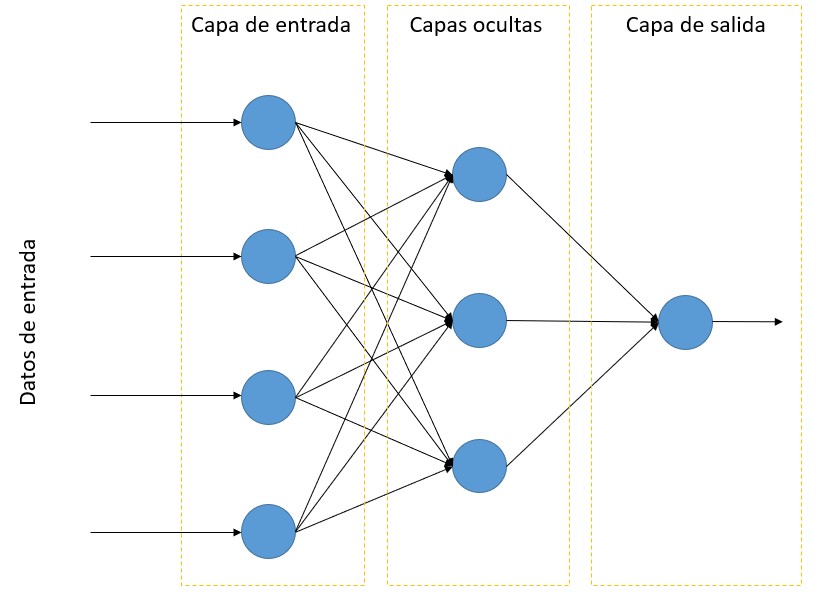

El esquema de este tipo de redes neuronales es el siguiente:

Cada uno de los círculos representa -con los matices comentados a continuación- una neurona.

En esta arquitectura tenemos -por convención- una capa de neuronas de entrada situada a la izquierda que, en realidad, no aplican ninguna función a los valores de entrada a la red. Es simplemente la forma que tenemos de indicar que los valores de entrada llegan de alguna forma a la red neuronal. Es decir, no son neuronas artificiales, aunque se representen como tales en el esquema anterior. En esta capa cada "neurona" recibe un único valor de entrada.

A continuación, tenemos una o más capas de neuronas en las que cada neurona está conectada con todas las neuronas de la capa anterior (o, dicho con otras palabras, los valores de entrada de una neurona son todos los valores devueltos por las neuronas de la capa anterior). Son las llamadas "capas ocultas".

Por último, tenemos una capa de salida formada por una o más neuronas, en función del tipo de análisis que se realice (análisis de regresión, de clasificación binaria o de clasificación multiclase).