Hagamos otro ejemplo. Partimos de los siguientes valores reales y la siguiente predicción:

y_real = [1, 1, 1, 1, 1, 1, 1, 0, 0, 0]

y_pred = [1, 1, 1, 1, 0, 0, 0, 0, 1, 1]

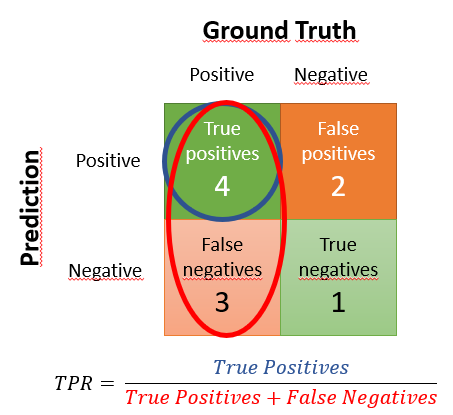

En este caso tenemos 10 elementos de los que 7 son positivos y 3 son negativos. Hemos marcado en nuestra predicción como positivos 6 elementos, de los que 4 son verdaderos positivos y 2 son falsos positivos. De forma semejante, hemos marcado 4 negativos, de los que 1 es un verdadero negativo y los otros 3 son falsos negativos.

La matriz de confusión devuelta por sklearn es:

confusion_matrix(y_real, y_pred)

array([[1, 2],

[3, 4]], dtype=int64)

En este caso, el recall o True Positive Rate vendría dado por el ratio mostrado en el siguiente esquema (matriz de confusión mostrada según el criterio más habitual):

Es decir, TPR = 4/7