El desarrollo de Mark Rosenblatt (los Perceptrones) suponían un tipo de arquitectura que hoy día se conoce en inglés como "feedforward neural networks" lo que, en español, puede traducirse como "redes neuronales prealimentadas" (a lo largo de este tutorial, sin embargo, en ocasiones serán mencionadas mezclando ambos idiomas: redes neuronales feedforward, o redes neuronales de tipo feedforward).

En esta arquitectura las señales de desplazan en una única dirección, desde la entrada de la red neuronal hasta la salida, sin formar ciclos.

El Perceptrón de Mark Rosenblatt era de este tipo, pero estaba basado en una capa única de unidades o neuronas dispuestas en paralelo. Estos perceptrones de capa única solo son capaces de clasificar datos linealmente separables, lo que limitaba enormemente su capacidad de aprendizaje y predicción.

En 1969 dos investigadores, Marvin Minsky y Seymour Papert, publicaron un libro ("Perceptrons") en el que mostraban cómo este tipo de redes neuronales eran incapaces de implementar la función XOR así como otras limitaciones de estas redes neuronales artificiales.

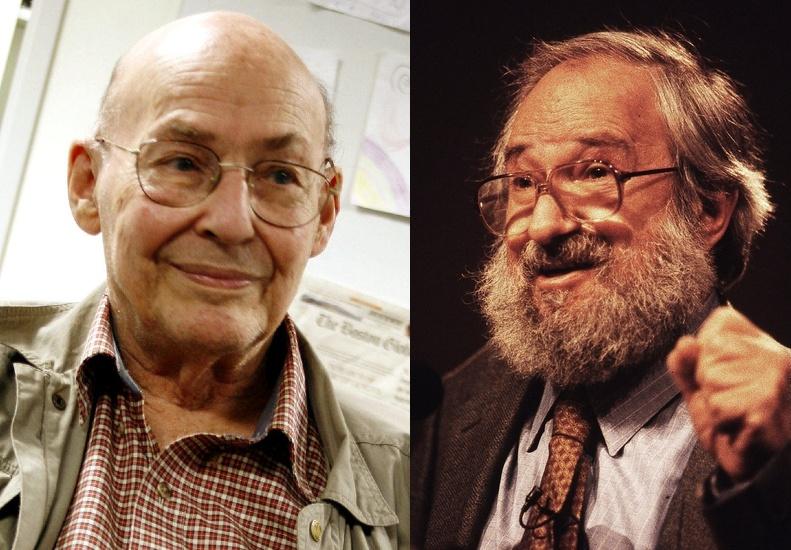

Marvin Minsky (izquierda) y Seymour Papert (derecha)