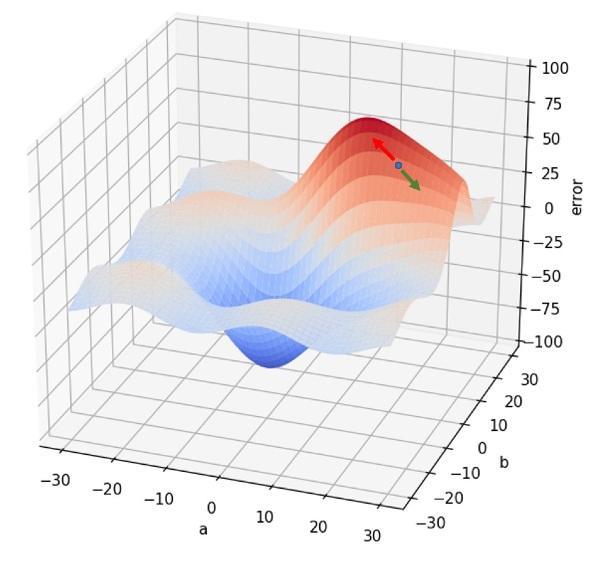

Lógicamente, si pasamos todos los datos por la red antes de calcular el gradiente de la función de error y modificamos los parámetros en función de la tasa de aprendizaje, habremos avanzado un poco en la dirección del mínimo. Pero deberemos repetir el proceso para seguir acercándonos y, eventualmente, alcanzarlo.

Cada vez que todos nuestros datos pasan por la red neuronal decimos que se ha completado un epoch. Resulta fácil entender que, con el proceso descrito, harán falta muchos epochs antes de que el entrenamiento de la red neuronal llegue a su fin.