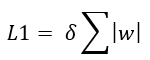

Ya hemos visto que la regularización nos permite limitar la complejidad del modelo y, de esta forma, reducir el riesgo de sobreentrenamiento. Comentamos que, aunque hay diferentes formas de aplicar este concepto, dos de los tipos de regularización más usados son la regularización L1 (también llamada regularización de Lasso), que agrega una penalización equivalente a la suma de los valores absolutos de los parámetros (la llamada distancia Manhattan):

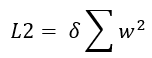

y la regularización L2 (también llamada regularización de Ridge), que aplica una penalización equivalente a la suma de los cuadrados de los parámetros (la distancia Euclídea):

El hecho es que la regularización L1 suele devolver vectores de coeficientes dispersos, con que queremos indicar que un cierto número de los coeficientes toman el valor 0, lo que supone un método de selección de características. Veamos cómo se realiza.