Apliquemos en algoritmo de regresión logística al dataset iris. Comencemos cargándolo y quedémonos solo con las species versicolor y virginica (clases no linealmente separables):

iris = iris[iris.species.isin(["versicolor", "virginica"])]

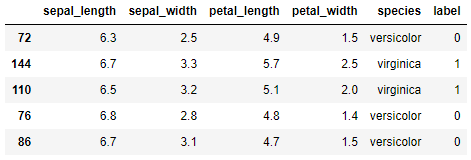

También aquí vamos a recurrir a codificar la etiqueta convirtiéndola a tipo categórico y extrayendo los códigos asignados (veremos otros métodos más adelante):

iris.sample(5)

Extraemos ahora las características predictivas (X) y la etiqueta (y):

y = iris.label

Dividimos ambas estructuras en un bloque de entrenamiento y otro de validación:

E importamos el algoritmo, lo instanciamos y lo entrenamos con el dataset de entrenamiento:

model = LogisticRegression(solver = 'lbfgs')

model.fit(X_train, y_train)

Por último, podemos confirmar el porcentaje de muestras bien clasificadas del dataset de validación ejecutando el método .score() del modelo (que ya sabemos que devuelve dicha métrica en tanto por uno):

La documentación ofrecida por Scikit-Learn al respecto de este algoritmo está disponible en esta página.

En este ejemplo se ha utilizado como algoritmo de optimización "lbfgs". Aunque la documentación no es muy extensa, podemos ver algunas de las diferencias entre los algoritmos disponibles (lbfgs, liblinear, newton-cg, newton-cholesky, sag y saga) aquí. Comprobamos que se distinguen principalmente en la versión de descenso de gradiente usada, así como en la regularización aplicada (de lo que se hablará más adelante).