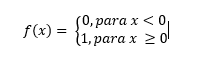

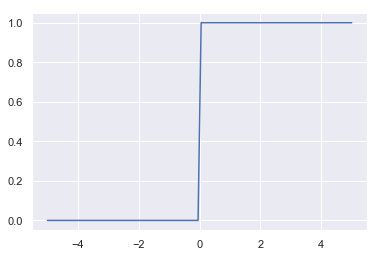

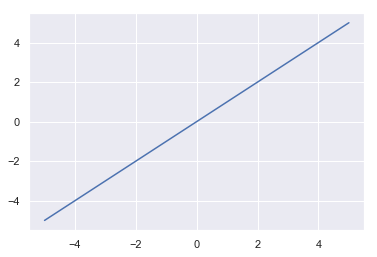

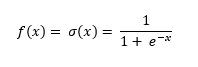

Se ha comentado que una de las diferencias entre las primeras neuronas artificiales y las modernas es el tipo de función de activación usada. Y es que las primeras funciones usadas (la función escalón de Rosenblatt y la función identidad de la Adaline) han ido dejando paso a otras funciones que se han mostrado mucho más eficientes. Se muestran a continuación algunos ejemplos de funciones de activación (se incluyen la función escalón y la función identidad solo por motivos pedagógicos):

| Nombre | Ecuación | Gráfica |

|---|---|---|

| Binary step |

|

|

| Identity |

|

|

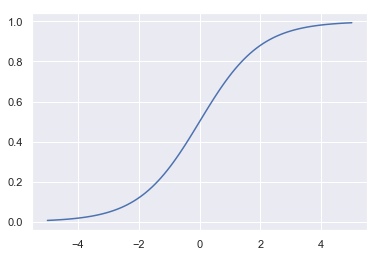

| Sigmoid or Logistic |

|

|

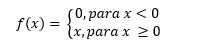

| Rectified Linear Unit (ReLU) |

|

|

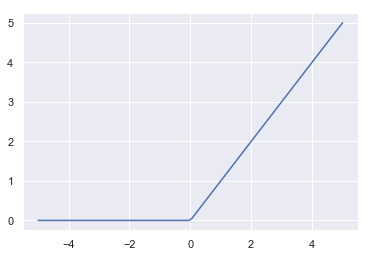

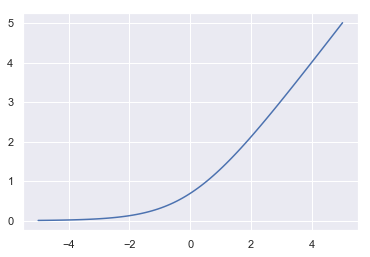

| SoftPlus |

|

|

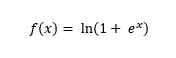

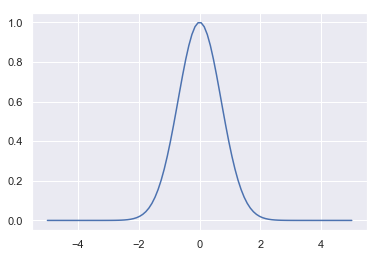

| Gaussian |

|

|

De éstas, una de las más usadas es la Rectified Linear Unit (frecuentemente llamada ReLU).